点击阅读英文原文

学术出版的数量和质量之间呈现出一种紧张关系,无论是决策者、资助者、大学管理者还是个人,这种紧张关系往往会触及研究决策的核心。

这是一个与“要么发表要么灭亡”文化交织在一起的问题,一些学者认为,这种文化已经导致研究如“切香肠”一般分割成尽可能小的出版单元,以求至少能够提高效率。在一些国家,学者的这种做法受到褒奖,他们每发表一篇论文,都会得到额外的奖励。这反过来又能反映出“重数量轻质量”的国家研究战略。即使是像英国的卓越研究框架这样更加强调质量的项目,也仍然期望学者在评估期内的研究数量达到一定规模。

资助者也热衷于这一观点——科学发现应该尽快传播出去。由于预印本服务器等数字创新的发展,这种欲望得到进一步加强。虽然这并不一定转化为倡导发表意大利香肠切片式的论文,但它可能会助长一种文化,即有些人担心匆忙出版会导致完整的、多年精心研究的成果无法汇集成真正有深度、有意义的科学论文。他们指出,历史上不乏发表论文相对较少,但成就非凡的学术巨匠。

从另一方面来看,那是不同的时代,人们不难产生疑问:有多少学者因为发表论文太少而在历史上籍籍无名——如果有的话。难道最优秀的人才不是成果最丰富的吗?同样,为发表论文做准备的过程,以及由此带来的多层次的反馈,难道不是一个强有力的机制,让学者成为更好的研究者吗?因此,效率在某种程度上不也是提高质量的一种手段吗?

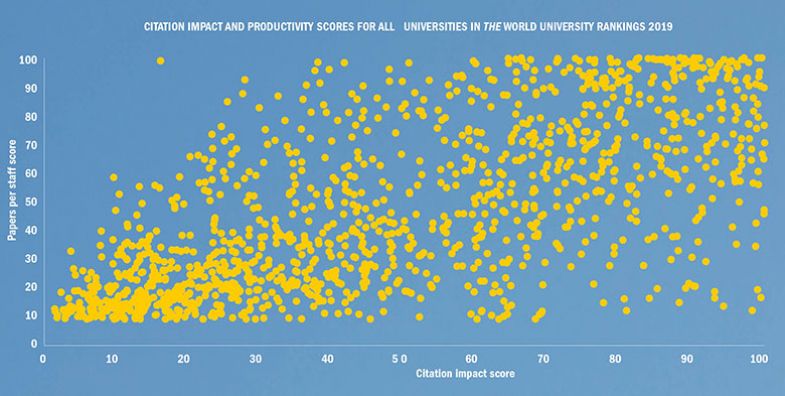

泰晤士高等教育自身的数据表明,效率和质量之间至少存在相关性。一所学术机构,人均发表的研究数量越多,引文影响力往往也越大。

2019年泰晤士高等教育世界大学排名引文影响力和效率得分完整榜单

在2019年泰晤士高等教育世界大学排名中,对1000多所大学中每一所大学都进行的一项图表调查显示,大部分大学要么集中在左下角,要么集中在右上角——在这些区域,大学在引文影响力和人均论文产出数量上的得分要么较低,要么较高。然而,也有许多大学不符合这一趋势。

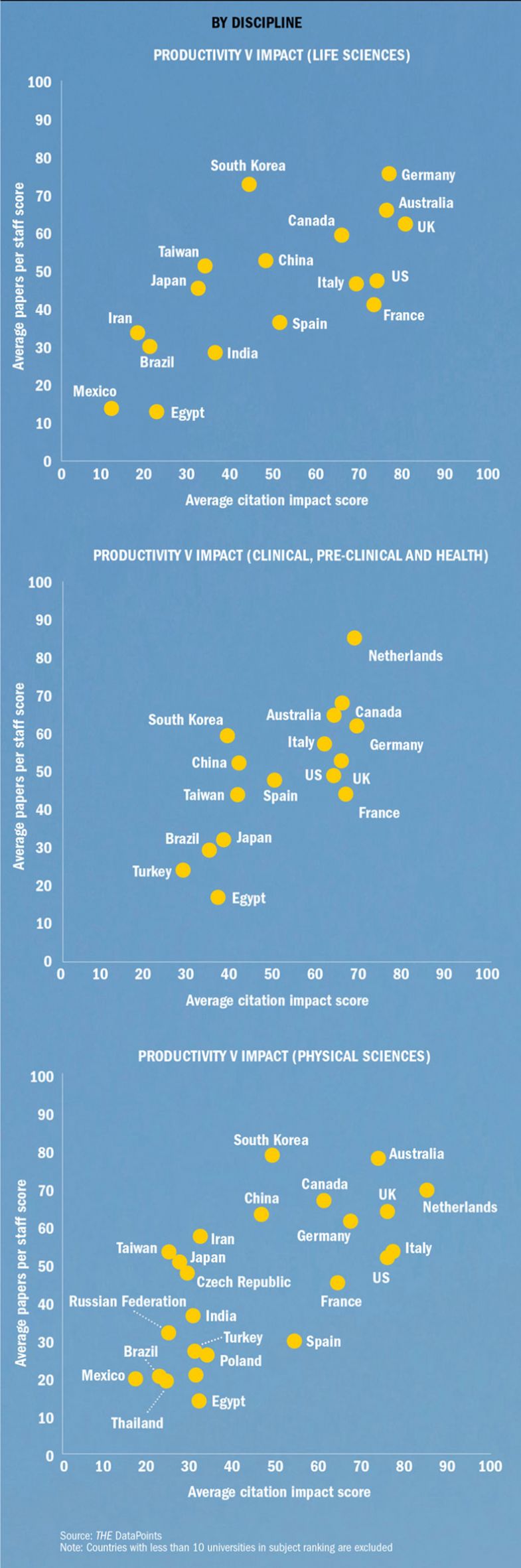

从国家层面来看,总体情况似乎也是如此。从至少有10所大学上榜的国家的平均分数分布图来看,结果再次表明,人均论文研究数量似乎与更高的引文影响力齐头并进。但这种关系远未明朗。例如,许多国家尽管效率较低,但平均引文影响力得分高于澳大利亚,而许多国家尽管效率较高,但在引文影响力方面落后于埃及。

效率与引文影响力之间的关系

此外,这些数据还远远达不到完美的程度。它们仅代表了世界上一些研究型大学,并反映了量表化分数。数据还假设,引文影响力是质量的体现,这一假设开启了一场大规模独立辩论,即这一度量标准在多大程度上真正反映了学术著作的价值。但是,就其价值而言,数据确实表明了效率和质量之间存在某种程度的关系。

二者之间存在某种联系,但充其量只是一个复杂的联系,贯穿在近年来为研究这个问题而开展的许多学术研究当中。

澳大利亚国立大学研究评估和政策项目前负责人琳达·巴特勒(Linda Butler)在2003年发表了一篇重要论文。这篇名为《澳大利亚在科学信息研究所出版物中所占比重增加的缘由——基于出版物数量的资助方案的影响》(Explaining Australia’s increased share of ISI publications – the effects of a funding formula based on publication counts)的论文,详细考察了澳大利亚在20世纪90年代世界研究产出中所占比重的增加,并揭示这似乎是以损害引文影响力为代价的。矛头直指以提高销量而非质量为目的的系统性激励措施。

“大量资金根据出版物总数分配给大学和大学各个部门,很少注重研究成果的影响力或质量。因此,在过去十年里,期刊出版效率显著提高,但影响力却反而下降了。”论文摘要中如此解释道。

对批评家而言,该论文可谓一记强心针,长期以来,他们一直声称,研究数量增长将不可避免地会损害质量。最近,通过2010年首次运行的澳大利亚卓越研究倡议,澳大利亚研究的质量得到了评估。

然而,其他研究人员已经表明,在个人层面上,有明确的证据表明,论文发表数量越大,引文影响力往往也更高。2016年,斯德哥尔摩瑞典皇家理工学院的乌尔夫·桑德斯特伦(Ulf Sandström)和阿姆斯特丹自由大学的彼得·范登·贝塞拉(Peter van den Besselaar)分析了近5万名瑞典研究人员的数据,发现效率提高和引文影响力增加二者之间存在“强相关性”。他们发现,在某些领域,每多发一篇论文,获得更多引用的概率也更高。

其他研究表明,高被引学者的核心群体在世界研究产出量和被引量上所占的比例大得惊人——这似乎很难说明出版数量的增加会损害质量。

桑德斯特伦认为,教育体系中有足够的安全措施来防止研究被切割得像意大利香肠切片一般支离破碎,影响质量,因为这样的论文根本就没有影响力。

他说:“如果你开始发表非常短小或信息很有限的论文,那么你的同事就会明白,它们是由论文发表机器所撰写的。人们可以骗自己,但我认为他们骗不了同事。”

他继续说道,抱怨意大利香肠切片式论文的“是那些自身不发表论文的人,我不确定是否应该听他们的。当我看到真正顶级的论文作者时,他们论文的引文影响力不高的情况极为罕见。”

其他人认为,自巴特勒的论文发表以来,学术界所进行的研究仅仅表明,效率和影响力之间的关系比人们以前认为的要复杂得多。

剑桥大学研究助理谢尔盖·科列斯尼科夫(Sergey Kolesnikov)是效率质量问题研究的合著者,他称,巴特勒的“开创性论文”似乎证实了“大多数科学家对以度量标准来治理科学这一做法的担忧,更多地来自自身的感知和经验:效率过高不利于提高科学引文影响力”。然而,后来科学计量学、研究评估,特别是数据科学的进展均表明,二者之间的关系是模糊的,而且要复杂得多。”

科列斯尼科夫说,具体而言,研究表明,“这种关系的程度和方向存在很大的变数,取决于研究人员的年龄、性别、资历、职业生涯长度、合作者数量、学术纪律或机构环境等因素”。

在亚利桑那州立大学任职期间,科列斯尼科夫曾从事一项研究,专门研究效率与化学和工程学科引文影响力之间的关系,以及不同学术群体之间的关系,这种关系是由他们开始职业生涯的时间来定义的。2018年发表在《科学计量学》上的研究结果表明,对于化学这个更容易将研究成果分成更小的单元发表的学科而言,发表论文数量越多,引文影响力就越小。但是在研究成果难以切分的工程学领域,通常看不到这样的趋势。

尽管这项名为《研究者平滑风险出版策略:效率与引文影响力是否水火不容?》(Researchers’ risk-smoothing publication strategies: is productivity the enemy of impact?)的研究只考察了化学和工程学两个学科,但这是一个例证,证明在不同的学科中,可能存在不同的效率-质量关系。

从泰晤士高等教育学科排名的数据来看,似乎也显示了各国因学科不同而在引文影响力和效率方面的不同相对表现。例如,在生命科学领域,效率较高的国家,引文影响力往往也更高。但是在自然科学、临床和健康领域,平均引文影响力相似的国家数量更多,不管它们的效率如何。

学术研究发现的另一个复杂因素是,处于不同职业阶段的学者,引文影响力受影响的方式也不同。科列斯尼科夫的研究表明,效率最高的工程学研究人员受益于可以积累优势的“马太效应”,他们的学术声誉建立得足够好,在职业生涯后期发表的任何东西受关注度都很高。

在其他研究中也有类似发现。2016年发表在《Plos One》上的一篇论文,使用了一个基于2800多万研究人员在33年间发表的巨大数据集,该论文发现,学者发表的学术论文越多,他们高被引论文的比重就越大。然而,这篇名为《多少才算太多?一项针对研究效率和引文影响力关系的研究》(How many is too many? On the relationship between research productivity and impact)的论文还指出,由于学科之间存在差异,“在年轻学者身上并不总是能发现这种模式”。

已确立地位的学者长期积累的声誉给了他们不公平的优势,这种说法尤其体现在对h指数的尖锐批评中。h指数声称能够衡量研究人员的能力,它试图将效率和引文影响力囊括进一个单一的数字当中——具体地说,指的是一名研究人员发表的引用次数达到一定程度的论文数量。正如科睿唯安科学信息研究所所长乔纳森·亚当斯(Jonathan Adams)去年向泰晤士高等教育指出的那样,因为h指数并没有真正考虑到积累引用次数所花费的时间,所以在更容易获得引用的学科,年龄较大的研究人员有明显的优势。

使用文献计量学来衡量效率,争议不如用它来衡量质量那么有争议,但也不是毫无争议。例如,上月发表在《Gigascience》杂志上的一篇论文分析了19世纪初以来的1.2亿多篇论文,结果发现,从1950年开始职业生涯的研究人员,在接下来的十年里平均每年发表1.55篇论文,而从2000年开始职业生涯的研究人员,平均每年发表4.05篇论文。但是,这项名为《学术出版指标的过度优化:古德哈特定律实证研究》(Over-optimisation of academic publishing metrics: observing Goodhart’s Law in action)的分析也发现,由于论文作者数量更多、论文更短以及出版物数量激增,自然科学论文拥有“成百上千名作者”的趋势越来越明显,并由此得出结论——“出版物数量不再是衡量学术成就的良好指标。”

蒙特利尔大学情报学副教授文森特·拉里维耶(Vincent Larivière)也参与撰写了上述发表在《Plos One》上的论文,他还在2016年另外撰写了一篇发表在《Plos One》上的论文,该论文分析了1900年至2013年间约4万名研究人员的发表模式。结果也发现,从表面上看,研究人员的效率似乎在逐年提高。然而,将合著者的人数考虑在内,将每篇论文的分数除以人数(称为分数计数)时,这种增长就消失了。因此才有了论文的题目——《研究人员的个人发表率一个世纪以来停滞不前》(Researchers’ individual publication rate has not increased in a century)。

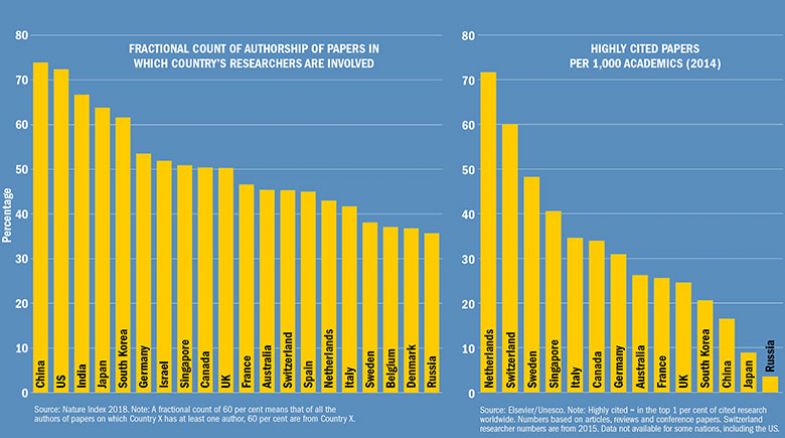

合著率的上升,意味着不使用分数计数的针对研究规模的测量——无论是个人、大学还是国家——可能会得出扭曲的结果。举例来说,如果研究人员每次都只参与由100多位作者合著的论文,他们是否真的像独立撰写论文的学者一样做了同样数量的研究?

通过比对绝对计数和分数计数数据,可以很容易地看出潜在的问题。自然指数(Nature Index)就是一个很好的例子,它分析了发表在82份高影响力自然科学期刊上的研究。国家排名因是否使用分数计数而异。

就效率而言,当考虑到作者是否真的像分数计数假设的那样对一篇论文做出了同样的贡献时,这个问题会变得更加棘手。科学领域的主要研究者尤其如此,他们可能没有进行过任何实验室工作。

拉里维耶说,问题的核心是“在研究体系中,为一篇论文增加一个作者毫不费力”。因此,他支持在论文结尾适当地列出每个人的贡献,以显示谁做了什么——包括学术领头人,他们在获取资助和管理研究方面可能仍然起到至关重要的作用。然而,拉里维耶说,为了有助于分析效率,所有期刊都需要采用这种形式,相对贡献“需要以某种方式编纂”,他承认这种方式很难被纳入研究体系。

丹尼尔·法内利(Daniele Fanelli)与拉里维耶合作撰写了那篇探讨效率与合著者关系的论文,他指出,尽管他们发现,学者发表的论文数量不一定增长,但论文“由于包含数据和分析,因此变得越来越长、越来越复杂、越来越丰富”。因此,他说,“科学家可能不像许多人所认为的那样,对发表意大利香肠切片式论文所面临的压力做出回应,而是通过合作来回应”。

拉里维耶说,总体而言,由于文献计量学极其复杂,并且存在一些问题,因此它们不应该被用来分析个人的表现。然而,引用次数仍然可以是“对于大学和国家而言,了解科学宏观结构、制定全球政策的一个很棒的工具”。

那么,到底是应该鼓励提高效率还是质量,大学管理者和政治家是怎么看待的呢?

在桑德斯特伦看来,每个学科群体都通过同行评审和引用次数来奖励最好的论文,政府和其他机构应该避免试图以任何方式操纵这个体系,他说:“应该支持研究人员,让他们决定如何处理这些事情。”

他补充道,像卓越研究框架这样限制大学和个人可以用于申请学分的出版物数量的方法“似乎很疯狂”。他甚至对类似《莱顿宣言》这样使用指标的指导方针持批评态度。考虑到不同学科在实践中存在巨大差异,他反问道:“提出对整个科学界普遍适用的规则意义何在?”

法内利也不相信“存在适用于所有情况的一般规则”,并补充道“任何政策都有成本和收益方面的考量”。

他说:“至少从20世纪50年代开始,就有人表达了对‘要么出版要么灭亡’这一文化有害影响的担忧。这些担忧的正当性是显而易见的。另一方面,研究体系若是不对研究人员的出版活动给予任何奖励或评定价值,就很难运作起来。一般来说,如果一名学者因将部分时间用于研究而获得报酬,那么雇主期望看到一些研究成果是合情合理的。这也符合整个社会的利益。从定义上来说,从未发表的研究成果是毫无价值的。”

然而,莱顿大学科技研究中心主任、《莱顿宣言》的作者之一莎拉·德·里切克(Sarah de Rijcke)表示,发表论文的压力在“发表期刊论文的竞争导致现有期刊版面紧张、付费出版和掠夺性期刊激增以及期刊影响力和引用统计数据受到操纵时,就会成为一个问题。当科学职业被明确设计,强调传统形式的效率时,这种压力也会成为问题。如果这个数字游戏不通过定性评估加以平衡,就会对科学产生害处。”

德·里切克认为,“在30年前”,鼓励人们发表更多论文可能是有道理的。“但是,总的来说,发表论文在当今研究者的日常工作中如此重要,我认为他们不需要外部机制来激励。”

谢菲尔德大学研究政策教授詹姆斯·威尔斯顿(James Wilsdon)领导了英国的2015年度量标准——《度量标准浪潮》(The Metric Tide)的运用评审工作,他同意:在发达国家的研究体系中,数量驱动因素似乎不再起作用。在北美和欧洲部分地区,大多数学者“有很高的内在动机去从事和产出高质量的研究成果”,所以问题在于如何组织资金,以充分利用这种动机

但是“在某些体系中,文化常态就是不产出研究成果,这就会成为一个问题……在那里,你可能需要体系提供更多外在的驱动因素来尝试提高科研成果数量”。

他表示,卓越研究框架已经从20世纪80年代最初的研究评估活动——当时它的使命是更公开地增加研究成果数量——发展到现在他所认为的注重质量,同时避免采取错误的激励方式。

最新卓越研究框架规定,允许研究人员按照下限,提交至少一项研究成果,这一举措“是相当明智的,因为它确实认识到,人们产出研究成果的形式和节奏不同……我认为,估计人们发表大量论文是一件非常糟糕的事情,估计人们发表少而优的论文则要好得多。”

那么,哪些国家体系似乎在数量和质量之间达到了正确的平衡?

通过分析每位学者所产出的被引用次数最高的研究数据表明,荷兰的研究体系值得其他国家借鉴。威尔斯顿认为,这可能得益于其融资和评估方法的多样性,以及其作为欧洲的“开放”体系,能够吸引其他国家的人才和合作。但与荷兰一样,在高引用研究效率方面得分较高的国家瑞士在国际合作中也占有很高的比重,这一事实引发了这样一个问题,即数据相互之间是否会产生影响。

作者和高被引研究之间的关系

另一个有趣的问题是,中国从数量驱动模式向质量驱动模式转变十分明显,以及对于任何新兴国家体系而言,这是否是自然的发展过程

法内利自己的研究将中国和印度认定为“科学不端行为的高风险国家”,他说,这“很有可能是因为在某些情况下,学者受到奖金的诱惑而发表论文”,他们每发表一篇论文都会得到现金奖励。例如,在印度,自2010年以来,职业发展一直与发表论文数量挂钩。直到2017年,它才推出一份经过审查的期刊清单,直到今年,它才采取措施,从数百份合法期刊中清除掉掠夺性期刊。然而,法内利补充道,正是在“排名低、努力想要出人头地”的大学里,贫乏的激励措施似乎效果最差,随着这些大学开始意识到试图在研究领域竞争是徒劳的,并采取差异化策略,将重心转向教学,这个问题可能会自行得到解决。

从长远来看,随着学术界对效率和引文影响力进行越来越详细的分析,像中国和印度这样的发展中国家的研究体系也可能从中受益。但是这些国家的政策制定者和政府部门是否会充分利用这一证据,还有待商榷。

剑桥大学的科列斯尼科夫(Kolesnikov)警告说:“不幸的是,我认为在这个问题上没有展开过政策辩论。学者和政策制定者之间需要加强相互对话和接触,以将‘科学之科学’领域的最新进展——包括我们对效率-引用之间关系的更深层理解——付诸政策实践。”

后记

Print headline: Quality versus quantity